Welcome

Open Knowledge è un network mondiale no-profit, nato nel 2004, di appassionati di openness, pronti a fare pressione, che fanno uso della tecnologia e della formazione per aprire informazioni e permettere così alle persone di creare e condividere conoscenza. La nostra missione Vogliamo vedere società illuminate in tutto il mondo, dove tutti hanno accesso a […]

Read moreDati e donne. Correlazioni pericolose e soffitti di cristallo

Lo scorso 3 marzo in una Bologna innevata per l’ennesima volta, alla vigilia delle elezioni politiche, a pochi giorni di distanza dalla marcia delle donne promossa dal movimento di Non una di meno e in occasione della giornata internazionale dedicata ai dati aperti, una comunità inedita ha promosso il primo di una serie di incontri […]

Read moreHackathon al Gran Sasso Science Institute! Iscrivetevi, avete tempo fino al 1 Luglio!

In occasione del Festival della Partecipazione, il Gran Sasso Science Institute (GSSI) organizza il 7 e 8 luglio prossimi a L’Aquila un Hackathon per sviluppare progetti di prodotti, di servizi o rappresentazioni visuali utili, sostenibili e replicabili, in grado di generare un impatto significativo nei modi di pensare, vivere e condividere la ricostruzione e le future […]

Read moreOpen Government Partnership: andare oltre l’agenda

Pubblichiamo un post che appare simultaneamente su altre testate e prodotto in condivisione con membri della società civile italiana impegnati nel processo di consultazione e partecipazione avviato da OGP Italia. Nel quadro del processo proposto dal Dipartimento della Funzione Pubblica (ministro Madia – Presidenza del Consiglio dei Ministri) alle organizzazioni della società civile per definire […]

Read moreOpen Education per il cambiamento sociale: seminario domani a Bologna!

Pubblichiamo a nome dei nostri amici e coordinatori del gruppo Open Education Working Group Domani, 23 Marzo, a Bologna, presso la sede del TIM#WCap in Via Guglielmo Oberdan, 22, si terrà il seminario “Educazione aperta per il cambiamento sociale in Italia” dalle ore 10.00 alle 16.00. Questo seminario nasce dalla necessità – emersa durante alcuni eventi che sono stati […]

Read moreCome gli studenti possono migliorare i fondi europei grazie agli open data e alle tecnologie civiche

Tre piccoli ma importanti passi sono stati fatti nelle scorse settimane verso politiche europee più aperte e partecipative. Si tratta di tre episodi di una serie di produttivi incontri tra policy maker che gestiscono i fondi europei e studenti armati di dati aperti e tecnologie civiche. Il monitoraggio civico dei fondi europei come metodo […]

Read moreFare Open Education in Italia: la piattaforma EduOpen

Dal 20 Aprile 2016 anche l’Italia ha la sua piattaforma nazionale per l’erogazione di Massive Open Online Courses, in gergo MOOCs. La piattaforma si chiama EduOpen, è il risultato di oltre un anno di lavoro di preparazione e coinvolge un consorzio di varie università (Università di Bari Aldo Moro, Politecnico di Bari, Università Libera di Bozen-Bolzano, […]

Read moreOpen Access Week 2015: Open for Collaboration

Come ogni autunno, ormai da 8 anni, anche questo Ottobre si svolgerà in tutto il mondo l’”International Open Access Week“. Quest’anno la settimana dedicata alla promozione dell’accesso libero alla conoscenza scientifica sarà dal 19 al 25 Ottobre. Il 4 Marzo 2015 SPARC (The Scholarly Publishing and Academic Resources Coalition) ha annunciato che il tema per […]

Read moreRiutilizzo dell’informazione giuridica: il progetto JurisWiki

Il fenomeno dell’open content si è soffermato principalmente sugli open data, poiché per certi versi consentono una maggiore semplicità di approccio rispetto ad altri tipi di informazioni. E’ il caso dell’informazione giuridica, che non è mai dato a sé stante, ma complesso articolato di espressioni linguistiche: leggi e decisioni dei giudici, nell’immaginario collettivo, non vengono facilmente […]

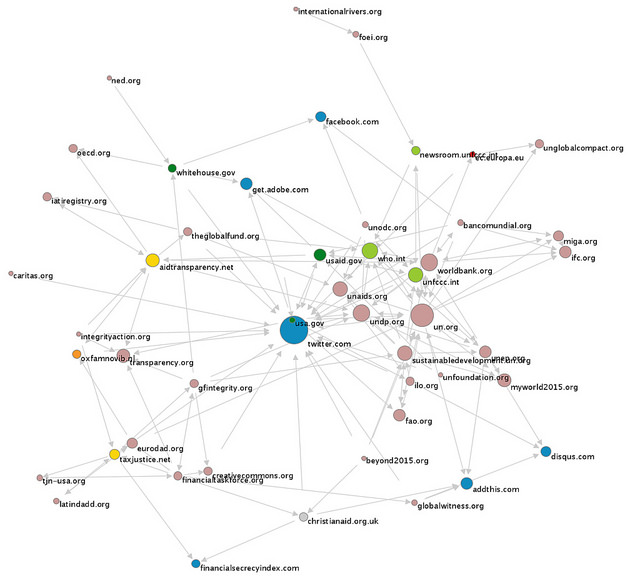

Read moreOpen budget data: un nuovo progetto per mapparne l’impatto

Jonathan Gray annuncia che sta per partire un nuovo interessante progetto di ricerca che esaminerà l’impatto dei dati di bilancio aperti (open budget data). Open Knowledge è coinvolta insieme a Digital Methods Initiative dell’ Università di Amsterdam, con il supporto di Global Initiative for Financial Transparency (GIFT). Un po’ di dettagli: il progetto includerà uno studio empirico […]

Read moreAperto il programma di micro finanziamenti per chi organizza l’Open Data Day: presenta oggi la domanda!

questo articolo è la versione italiana di Launching Open Data Day Coalition Micro-Grant Scheme: Apply Today! OPEN DATA DAY 2015 è alle porte, e diversi partner si sono uniti per fornire un numero limitato di micro-finanziamenti destinati a sostenere le comunità che organizzano attività ODD in tutto il mondo! L’Open Data Day (ODD) è uno […]

Read more